🤖 Como Reduzir Alucinações em GenAI: Técnicas e Desafios 🤖

- #Claude 3

- #Adaptabilidade

- #Machine Learning

- #Python

- #IA Generativa

- #Inteligência Artificial (IA)

- #OpenAI Agents

- #Inovação

--------------------------------------------------------------

Larissa Campos Cardoso.

Centro Universitário do Triângulo.

ORCID: 0009-0009-6869-2799.

Grupo de Realidade Virtual e Aumentada (GRVA) - Universidade Federal de Uberlândia.

Uberlândia, Minas Gerais, Brasil.

Contato: larissacamposcardoso@gmail.com. Portfólio. Linkedin.

--------------------------------------------------------------

Prof. Dr. Alexandre Cardoso

Universidade Federal de Uberlândia

ORCID: 0000-0002-2023-9647

Chefe do Grupo de Realidade Virtual e Aumentada (GRVA) - Universidade Federal de Uberlândia.

Uberlândia, Minas Gerais, Brasil.

Contato: alexandre@ufu.br. Linkedin.

--------------------------------------------------------------

🤖 𝓒𝓸𝓶𝓸 𝓡𝓮𝓭𝓾𝔃𝓲𝓻 𝓐𝓵𝓾𝓬𝓲𝓷𝓪𝓬̧𝓸̃𝓮𝓼 𝓮𝓶 𝓖𝓮𝓷𝓐𝓘: 𝓣𝓮́𝓬𝓷𝓲𝓬𝓪𝓼 𝓮 𝓓𝓮𝓼𝓪𝓯𝓲𝓸𝓼 🤖

Resumo:

Este artigo explora as diversas abordagens técnicas e científicas que visam reduzir as alucinações em modelos de Inteligência Artificial Generativa (GenAI). Aborda as causas subjacentes dessas alucinações, as estratégias de mitigação mais eficazes, as métricas de avaliação utilizadas para quantificar o problema e as perspectivas futuras na busca por modelos de GenAI mais confiáveis e precisos. A análise é fundamentada em estudos revisados por pares e evidências empíricas recentes, oferecendo uma visão abrangente do estado da arte e dos desafios remanescentes.

Abstract:

This article explores the various technical and scientific approaches aimed at reducing hallucinations in Generative Artificial Intelligence (GenAI) models. It addresses the underlying causes of these hallucinations, the most effective mitigation strategies, the evaluation metrics used to quantify the problem, and future perspectives in the search for more reliable and accurate GenAI models. The analysis is based on peer-reviewed studies and recent empirical evidence, offering a comprehensive overview of the state of the art and remaining challenges.

Sumário:

Introdução

- O Que São Inteligências Generativas?

- 1.1. Definição e Aplicações

- 1.2. Como Funcionam as Inteligências Generativas

- O Que São Alucinações em GenAI?

- Causas Técnicas das Alucinações

- Estratégias de Mitigação

- Alinhamento por Reforço com Feedback Humano (RLHF)

- Geração Aumentada por Recuperação (RAG)

- Verificação Factual Automática

- Curadoria de Dados

- Ajuste de Incerteza

- Fine-tuning de Domínio

- Métricas de Avaliação

- Factual Consistency Score (FCS)

- TruthfulQA

- Hallucination Rate (HR)

- Resultados e Aplicações

- Perspectivas Futuras

- Conclusão

- Referências

- Mini Dicionário

Introdução

A crescente adoção de Modelos de Inteligência Artificial Generativa (GenAI) como GPT, Claude e Gemini, trouxe uma revolução na forma como humanos interagem com sistemas computacionais. No entanto, essa evolução vem acompanhada de um desafio significativo: as alucinações, fenômeno no qual o modelo gera informações incorretas ou inventadas com aparência de veracidade [1].

Este artigo tem como objetivo apresentar e discutir estratégias eficazes para reduzir as alucinações em modelos de GenAI, com base em fundamentos científicos sólidos e resultados empíricos.

1. O Que São Inteligências Generativas?

1.1. Definições e Aplicação?

Inteligência Artificial (IA) é um ramo da ciência da computação que se concentra no desenvolvimento de sistemas e algoritmos capazes de realizar tarefas que normalmente exigem inteligência humana. Essas tarefas incluem:

- Aprendizado;

- Raciocínio;

- Percepção;

- Compreensão e geração de linguagem natural;

- Reconhecimento de voz e imagem;

- Tomada de decisão; e

- Resolução de problemas complexos.

Embora a IA tenha suas origens na década de 1950, foi nas últimas décadas que seu desenvolvimento acelerou, com avanços significativos em hardware, software e técnicas de aprendizado. Além disso, o volume de dados disponível também aumentou, possibilitando “ensinar” essas IAs de forma mais efetiva.

A IA tem sido aplicada em uma ampla gama de situações, como: assistentes virtuais, veículos autônomos, análise de dados, medicina, finanças, entretenimento e muito mais, transformando a maneira como vivemos e trabalhamos. [21]

1.2. Como funcionam as Inteligências Generativas?

Existem diversas técnicas e algoritmos para se ensinar uma máquina a realizar uma tarefa. Na maior parte dos casos, quando ouvimos falar de IA, estamos falando de algoritmos de Machine Learning.

Em algoritmos de Machine Learning supervisionados, por exemplo, a ideia principal é que, após um processo que chamamos de treinamento, seja construído um modelo capaz de fazer uma conexão entre um tipo de entrada desejada com uma saída desejada.

Além disso, existem outras abordagens que fogem às aplicações supervisionadas. Um exemplo são os algoritmos não supervisionados que recebem dados sem informações de uma saída desejada e são capazes de identificar padrões.

Um outro exemplo é o aprendizado por reforço onde os algoritmos aprendem a tomar decisões através da interação com um ambiente, recebendo feedback na forma de recompensas ou punições. [22]

2. O Que São Alucinações em GenAI?

As alucinações em modelos generativos ocorrem quando a IA produz respostas inconsistentes com a realidade factual ou logicamente incorretas [2].

Elas podem ser classificadas em três categorias principais:

- Alucinações factuais: quando a IA inventa fatos inexistentes (ex.: "Einstein ganhou dois Prêmios Nobel").

- Alucinações lógicas: quando o modelo chega a conclusões erradas a partir de premissas corretas.

- Alucinações referenciais: quando cita fontes falsas, DOIs inexistentes ou autores que nunca publicaram sobre o tema.

Esses erros comprometem a confiança, a usabilidade e a segurança de sistemas baseados em GenAI [3].

3. Causas Técnicas das Alucinações

Várias causas contribuem para o fenômeno das alucinações:

- Treinamento com dados ruidosos: bases de dados contendo informações falsas, desatualizadas ou contraditórias [4].

- Ausência de grounding: falta de conexão direta entre a geração de texto e fontes verificáveis em tempo real [5].

- Decodificação probabilística: o processo de sampling (como top-k ou nucleus sampling) pode gerar respostas não determinísticas [6].

- Ausência de feedback humano contínuo: modelos sem Reinforcement Learning from Human Feedback (RLHF) são mais propensos a erros de coerência [7].

4. Estratégias de Mitigação

Para enfrentar o problema das alucinações, diversas técnicas e abordagens foram desenvolvidas e implementadas:

→ Alinhamento por Reforço com Feedback Humano (RLHF): Esta técnica envolve o uso de feedback humano para supervisionar e refinar as respostas geradas pelo modelo, incentivando a produção de informações mais precisas e alinhadas com as expectativas humanas [8].

→ Geração Aumentada por Recuperação (RAG): A RAG conecta o modelo a bases de conhecimento externas, permitindo que ele recupere informações relevantes e as utilize para fundamentar suas respostas, reduzindo a dependência de informações potencialmente imprecisas armazenadas em seus parâmetros [10].

→ Verificação Factual Automática: Esta abordagem integra módulos de checagem factual que verificam automaticamente a precisão das informações geradas pelo modelo, comparando-as com fontes de conhecimento confiáveis [12].

→ Curadoria de Dados: A curadoria de dados envolve a seleção e o processamento cuidadoso dos dados de treinamento, priorizando informações revisadas, verificáveis e de alta qualidade [14].

→ Ajuste de Incerteza: Esta técnica penaliza as respostas de baixa confiança geradas pelo modelo, incentivando-o a produzir informações apenas quando tiver um alto grau de certeza [15].

→ Fine-tuning de Domínio: O fine-tuning de domínio especializa o modelo em contextos técnicos específicos, permitindo que ele desenvolva um conhecimento mais profundo e preciso sobre áreas de conhecimento particulares [16].

Exemplo de implementação de Fine-tuning em pseudocódigo:

# Modelo pré-treinado

model = load_model("gpt2")

# Preparar o conjunto de dados

data = load_data("data_domain.txt")

tokenized_data = tokenize(data, limit=512)

# Definir paramêtros

parameters = {

"season": 3,

"learning_rate": 2e-5,

"lote_size": 4

}

# Fine-tuning

training = Training(model, tokenized_data , parameters)

trainer.train()

# Salva

model_saved(model, "finetuned_model")

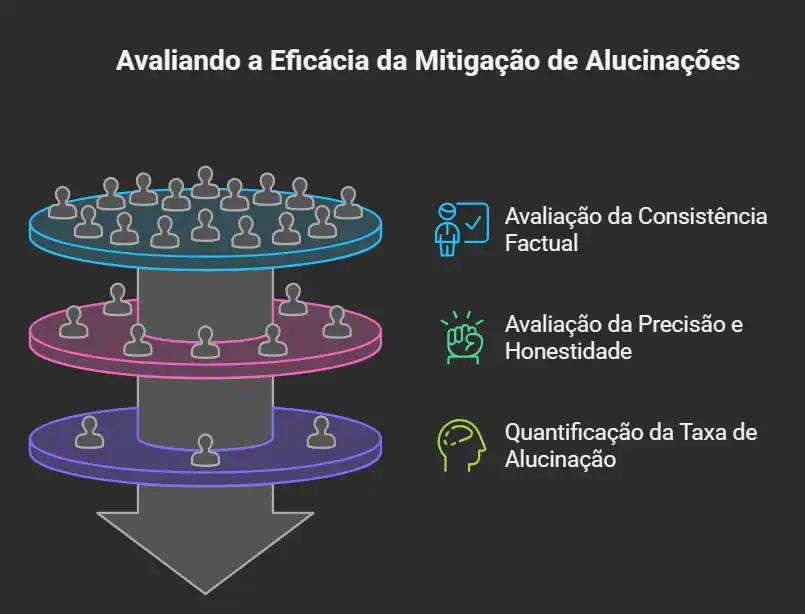

5. Métricas de Avaliação

Para quantificar e monitorar a eficácia das estratégias de mitigação, diversas métricas de avaliação foram desenvolvidas:

- Factual Consistency Score (FCS): Esta métrica mede a consistência factual das informações geradas pelo modelo, comparando-as com fontes de conhecimento externas.

- TruthfulQA: O TruthfulQA é um benchmark que avalia a capacidade do modelo de responder a perguntas de forma precisa e honesta, evitando a geração de informações falsas ou enganosas [17].

- Hallucination Rate (HR): Esta métrica quantifica a frequência com que o modelo gera alucinações, fornecendo uma medida direta do problema.

6. Resultados e Aplicações

Empresas de ponta aplicam múltiplas estratégias combinadas:

- OpenAI: integra RLHF, RAG e post-verification models em pipelines paralelos.

- Google DeepMind: aplica aprendizado contínuo supervisionado com knowledge retrieval.

- Anthropic: utiliza princípios de IA constitucional, incorporando regras explícitas de veracidade e ética [19].

Esses casos demonstram que a mitigação de alucinações não é uma solução única, mas sim um ecossistema de técnicas complementares.

7. Perspectivas Futuras

Apesar dos avanços, a eliminação completa das alucinações ainda é inviável. Os principais desafios incluem:

- Escalabilidade do RLHF, devido ao alto custo humano.

- Dificuldade em definir o que é “verdade” em contextos ambíguos.

- Necessidade de transparência em dados proprietários.

- Desenvolvimento de métricas universais de factualidade.

Tendências futuras apontam para o uso de LLMs híbridos com raciocínio simbólico, permitindo validação lógica formal antes da resposta final [20].

8. Conclusão

A redução de alucinações em GenAI é um campo interdisciplinar, combinando linguística computacional, aprendizado de máquina e epistemologia da informação. Estratégias como RLHF, RAG, fact-checking automático e curadoria de dados são hoje as mais eficazes. O futuro da IA confiável depende da integração contínua entre humanos e máquinas, em um ciclo de aprendizado supervisionado e auditável.

9. Referências:

[1] Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., ... & Fung, P. “Survey of Hallucination in Natural Language Generation.” ACM Computing Surveys, vol. 55, no. 12, pp. 1–38, 2023. DOI: 10.1145/3571730

[2] Maynez, J., Narayan, S., Bohnet, B., & McDonald, R. “On Faithfulness and Factuality in Abstractive Summarization.” ACL, 2020. DOI: 10.18653/v1/2020.acl-main.173

[3] Ji et al., op. cit., p. 14.

[4] Mitchell, M. “Artificial Intelligence: A Guide for Thinking Humans.” Farrar, Straus and Giroux, 2020.

[5] Lewis, P. et al. “Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks.” NeurIPS, 2020. DOI: 10.48550/arXiv.2005.11401

[6] Holtzman, A., Buys, J., Du, L., Forbes, M., & Choi, Y. “The Curious Case of Neural Text Degeneration.” ICLR, 2020. DOI: 10.48550/arXiv.1904.09751

[7] Christiano, P. F. et al. “Deep Reinforcement Learning from Human Preferences.” NeurIPS, 2017. DOI: 10.48550/arXiv.1706.03741

[8] Bai, Y. et al. “Training a Helpful and Harmless Assistant with RLHF.” Anthropic Research, 2022. DOI: 10.48550/arXiv.2204.05862

[9] OpenAI. “GPT-4 Technical Report.” OpenAI, 2023. DOI: 10.48550/arXiv.2303.08774

[10] Lewis et al., op. cit.

[11] Shuster, K. et al. “BlenderBot 3: A Deployed Conversational Agent that Continually Learns to Reduce Toxicity and Hallucination.” Meta AI, 2022. DOI: 10.48550/arXiv.2208.03188

[12] Kryscinski, W. et al. “Evaluating the Factual Consistency of Abstractive Text Summarization.” EMNLP, 2020. DOI: 10.48550/arXiv.1910.12840

[13] Lee, J. Y., & Lim, H. “FactCC: Factual Consistency Classifier for Text Generation.” EMNLP Findings, 2021. DOI: 10.48550/arXiv.2104.08307

[14] Gao, T. et al. “Making Pre-trained Language Models Better Few-shot Learners.” ACL, 2021. DOI: 10.48550/arXiv.2012.15723

[15] Malinin, A., & Gales, M. “Predictive Uncertainty Estimation via Prior Networks.” NeurIPS, 2018.

[16] Gururangan, S. et al. “Don’t Stop Pretraining: Adapt Language Models to Domains and Tasks.” ACL, 2020. DOI: 10.48550/arXiv.2004.10964

[17] Lin, S. et al. “TruthfulQA: Measuring How Models Mimic Human Falsehoods.” ACL, 2022. DOI: 10.48550/arXiv.2109.07958

[18] OpenAI, op. cit., p. 72.

[19] Bai et al., op. cit.

[20] Nye, M. et al. “Show Your Work: Scratchpads for Intermediate Computation with Language Models.” NeurIPS, 2022. DOI: 10.48550/arXiv.2112.00114

[21] Guia para a IA generativa na educação e na pesquisa. Holmes, W. Miao, F. DOI: 9789237000281. Available at: https://books.google.com.br/books?id=bTAQEQAAQBAJ. 2024. UNESCO Publishing.

[22] O que é Inteligência Artificial? Como funciona uma IA, quais os tipos e exemplos. Available at: https://alura.com.br/artigos/inteligencia-artificial/inteligencia-artificial-ia. 2023. ALURA.

10. Mini Dicionário:

Alucinações (Hallucinations):

Fenômeno em que modelos de IA generativa produzem informações incorretas, incoerentes ou inexistentes, apresentadas de forma convincente e aparentemente verídica.

Grounding:

Processo de conectar a geração textual de um modelo de IA a fontes externas e verificáveis, garantindo que suas respostas estejam ancoradas em dados reais e atualizados, reduzindo o risco de alucinações.

RLHF (Reinforcement Learning from Human Feedback):

Método de treinamento baseado em aprendizado por reforço no qual avaliadores humanos fornecem feedback sobre as respostas do modelo, orientando-o a priorizar respostas úteis, éticas e factualmente corretas.

RAG (Retrieval-Augmented Generation):

Arquitetura que combina recuperação de informações (retrieval) com geração de texto, permitindo que o modelo consulte bases externas antes de formular uma resposta, melhorando a precisão e o contexto.

Fact-Checking Automático:

Mecanismo computacional que valida a veracidade das informações produzidas pela IA, comparando-as com fontes confiáveis ou bases de dados estruturadas.

Hallucination Rate (Taxa de Alucinação):

Indicador quantitativo que mede a frequência com que um modelo de IA gera informações incorretas em relação ao total de saídas produzidas.

Factual Consistency Score (FCS):

Métrica de avaliação que verifica o grau de consistência factual entre a saída do modelo e as fontes de referência, indicando o quanto o conteúdo gerado é verdadeiro.

TruthfulQA:

Benchmark amplamente utilizado para avaliar a honestidade e a precisão factual das respostas geradas por modelos de linguagem, penalizando respostas enganosas ou ilusórias.

Fine-Tuning de Domínio:

Processo de especialização de um modelo de linguagem em um campo técnico ou temático específico, usando conjuntos de dados ajustados ao domínio para aumentar a precisão e reduzir alucinações contextuais.

Curadoria de Dados:

Etapa de seleção, filtragem e organização de dados de treinamento, que visa garantir a inclusão apenas de informações verificáveis, balanceadas e representativas.

Decodificação Probabilística:

Mecanismo de geração textual em modelos de linguagem que escolhe palavras com base em distribuições de probabilidade (como top-k ou nucleus sampling), podendo introduzir variabilidade e, por consequência, alucinações.

Knowledge Retrieval:

Componente de sistemas de GenAI responsável por buscar e recuperar informações relevantes de bases externas, servindo como base para a formulação de respostas mais precisas.

Modelos Híbridos com Raciocínio Simbólico:

Nova geração de modelos que combina redes neurais com mecanismos simbólicos de lógica formal, permitindo validação racional antes da emissão da resposta final.

Epistemologia da Informação:

Campo interdisciplinar que estuda a natureza, a origem e a validação do conhecimento dentro dos sistemas de informação e inteligência artificial.